La Inteligencia Artificial de alguna forma pretende pensar y/o actuar como humanos. Son muchos los ejemplos de cómo se intenta emular de forma artificial lo que durante miles de años de evolución ha sido creado de forma “natural”. Ejemplo de esto son los robots humanoides o las redes neuronales artificiales que imitan nuestras propias neuronas.

Últimamente es común encontrar en prensa noticias mostrando el “poder de la IA” con ejemplos de ésta “compitiendo” contra humanos. No hace mucho, por ejemplo, salía a la luz una competición, en China, entre algunos de los mejores especialistas del país y una IA en la detección de tumores cerebrales. Por supuesto, los medios se hacen eco de la supuesta victoria de la IA (de haber “ganado” los humanos el artículo hubiera tenido mucha menos repercusión).

Este tipo de noticias no hace sino fomentar la idea de que en un futuro cercano estas Inteligencias artificiales acabaran con miles de puestos de trabajo y nos convertirán en componentes obsoletos en un cada vez más competitivo proceso productivo y asistencial.

Sin embargo, mi visión y por tanto la de TedCas sobre el uso de tecnologías como la IA o la Realidad Aumentada o Virtual tiene un enfoque distinto. Somos firmes defensores de la aplicación de estas nuevas tecnologías para facilitar y ayudar a los profesionales, y no para sustituirlos. Por supuesto que somos conscientes de que hay un número de puestos de trabajo realizando monótonas y repetitivas tareas que pueden ser cubiertos por robots, inteligencias artificiales… pero esto no es ninguna novedad.

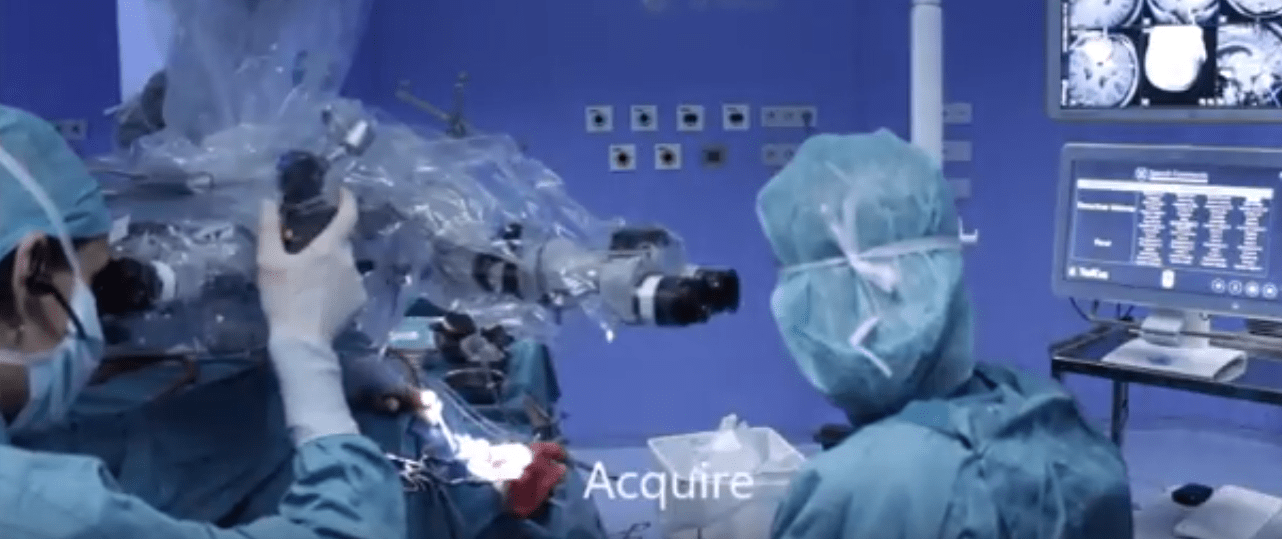

Pero tratemos de concretar este nuevo ambiente de colaboración entre la IA y profesionales. Lo haremos con algunos ejemplos de aplicaciones que en TedCas hemos realizado tanto en el ámbito asistencial como en el industrial. Comenzando con un ámbito concreto de la IA como es el procesado de lenguaje natural (NLP). Empecemos el viaje por un quirófano.

¿Qué problema existe en este entorno?

En condiciones de limpieza y esterilidad máxima, el cirujano no puede consultar información sin un ayudante, ya que no puede tocar nada. Tener una persona entre tú y el equipamiento que quieres controlar no sólo tiene la obvia desventaja de utilizar un recurso valioso como “control remoto humano” sino que además genera estrés, hace perder tiempo….

¿Cómo la IA de TedCas ha solucionado este problema?

Por aplicar un símil, hemos creado una especie de Alexa o Siri para quirófano. Nuestra IA no ha causado ningún despido, sino que las personas que antes actuaban como “controles remotos humanos” ahora pueden atender a tareas más productivas e, incluso, si querían seguir controlando ellos el equipo, la IA les simplificaba la tarea.

Siguiendo en entorno sanitario pero moviéndonos fuera del quirófano, estamos trabajando con Mutua de Navarra para la aplicación en la redacción de informes y gestión documental mediante la voz.

¿Qué problema existe en este entorno?

Los profesionales sanitarios al pasar consulta han pasado de tener un trato cercano y humano con el paciente a ser casi mecanógrafos, pasando más tiempo redactando el informe que mirando a los ojos al paciente y escuchando sus problemas. Esto creo un empeoramiento de la calidad asistencial y una peor experiencia para ambos médico y paciente.

¿Cómo la IA de TedCas y Mutua Navarra están solucionando ese problema?

De nuevo, el asistente por voz permite al médico solucionar el problema, ya que puede redactar el informe por voz mientras habla y mira al paciente. Además, el proyecto con Mutua Navarra va incluso más allá del entorno asistencial, ya que el dictado de los informes permitirá ahorrar un tiempo valioso y dotar de movilidad y flexibilidad a personal de administración, gerencia…

Pero la IA no es la última tecnología que pretende imitar el comportamiento de los seres humanos para realizar o facilitar la realización de trabajos que antes eran complejos de realizar. Otro ejemplo claro de esto son las tecnologías que “aumentan nuestra realidad” (Realidad Virtual (VR), Realidad Aumentada (AR), Realidad Mixta (MR)…)(Denominadas XR en general).

Estas tecnologías pretenden dotar al ser humano de una información visual (y auditiva) añadida a la existente en su entorno (y en algunos casos como la realidad virtual, sustitutiva de la de su entorno).

Pero de nuevo, pongamos algunos ejemplos concretos del uso de estas tecnologías y de cómo están ayudando a profesionales de varios sectores:

Comencemos con la realidad virtual. Esta pretende que simplemente poniéndote unas gafas “opacas” (no verás lo que tienes alrededor) puedas transportarte a un mundo totalmente distinto. Pero lejos de ser simplemente una tecnología lúdica, tiene aplicaciones muy útiles en el entorno profesional.

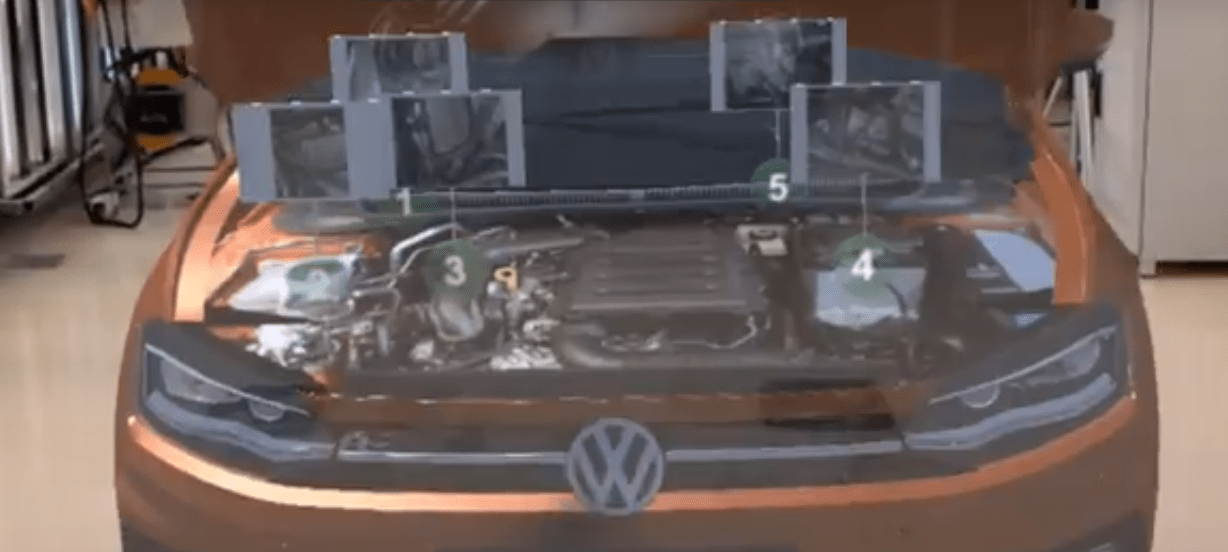

Pongamos simplemente el ejemplo de uno de nuestros clientes en automoción.

¿Qué problema existe en este entorno?

Antes de que se disponga del modelo de coche real a fabricar, estas fábricas tienen que formar a sus revisores, trabajadores…en cómo será el nuevo modelo. En condiciones normales lo que hacen es ponerles vídeos, hacerles presentaciones, enseñarles planos en un ordenador…siendo muy poco atrayente y poco práctico para personas que están acostumbradas a entrar en contacto con el coche real.

¿Cómo la VR de TedCas ha solucionado este problema?

Se ha recreado un coche a tamaño real con todas sus piezas. Cuando un usuario se pone las gafas, se transporta a un mundo en el que puede entrar, salir, ver los recovecos…de ese coche. Pero no sólo eso, puede “despiezarlo”, separarle por capas con sólo dar un comando de voz, puede cambiarle la pintura, el modelo de chapa…

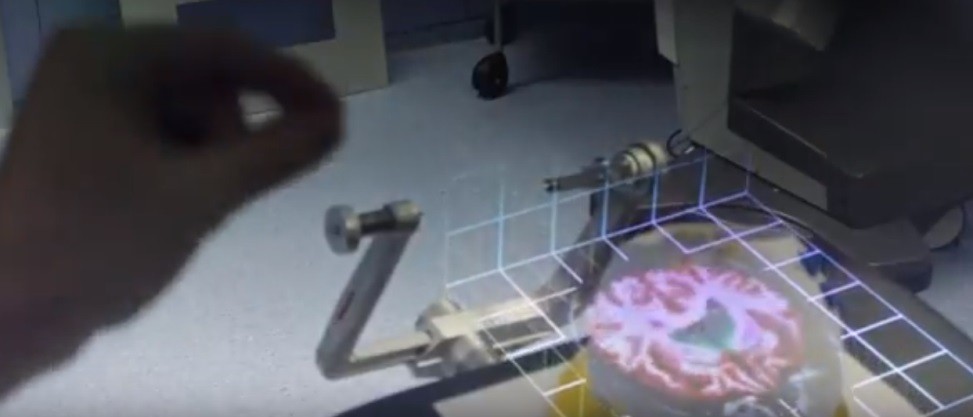

Moviéndonos hacia la Realidad Mixta. Esta pretende aunar las dos grandes ventajas de la VR y de la AR. En este caso, las gafas tienen un visor transparente que te deja ver tu “realidad” pero a la vez, permite proyectar (y posicionar) sobre esa realidad elementos en 3D (y no sólo elementos 2D cómo ocurre tradicionalmente con la AR).

En este caso pongamos como ejemplo un trabajo en colaboración con Mutua Navarra en el ámbito de la traumatología.

¿Qué problema existe en este entorno?

El profesional sanitario le hace unas pruebas (un scanner) al paciente, siendo posible luego ver en el ordenador, por ejemplo, cómo es la columna vertebral y elementos alrededor de la misma del paciente. Sin embargo, cuando tiene que hacer a ese paciente, por ejemplo, una punción lumbar, el médico tiene que imaginarse cómo sería proyectar esa imagen del ordenador en el cuerpo del paciente en la posición en la que éste esté en ese momento (no es tarea sencilla).

¿Cómo la MR de TedCas ha solucionado este problema?

Hemos creado un modelo virtual en 3D a partir del estudio del paciente y una vez que el profesional se pone las gafas y mira al paciente, éstas saben dónde proyectar ese estudio 3D y le dan al médico una especie de “visión de rayos X” que le permite acertar con la punción sin problemas.

Contacto

Contacto

No hay comentarios disponibles, ¡sé la primera persona en comentar!